لماذا يجب ألا نطلب من الذكاء الاصطناعي توضيح طريقة عمله؟

يمكن أن يؤدي تصميم شبكات عصبونية أكثر شفافية إلى المبالغة بالثقة فيها. وقد يكمن الحل في تغيير طريقة شرحها لعملها.

ركب أوبول إحسان ذات مرة في إحدى سيارات أوبر ذاتية القيادة. وبدلاً من الشعور بالقلق عند النظر إلى مقعد السائق الفارغ، كانت الشركة تشجع الركاب على مشاهدة شاشة "مهدئة" تبين نظرة السيارة للطريق، حيث توضح المخاطر باللون البرتقالي والأحمر، والمناطق الآمنة بالأزرق الهادئ. وبالنسبة لإحسان، الذي يدرس تفاعل البشر مع الذكاء الاصطناعي في معهد جورجيا للتكنولوجيا في أتلانتا، كانت الرسالة المقصودة واضحة: "لا داعي للذعر، هكذا تعمل السيارة". ولكن شيئاً ما في المنظر الغريب للشارع في الشاشة عزَّز من غرابة التجربة بدلاً من الشعور بالاطمئنان إزاءها. وهو ما شجع إحسان على التفكير في السؤال التالي: ماذا لو كانت السيارة ذاتية القيادة قادرة على تفسير طريقة عملها بشكل حقيقي؟

يُعزى نجاح التعلم العميق بشكل أساسي إلى العبث والتجريب المتواصل، حيث يجري تعديل أفضل الشبكات وتكييفها للحصول على شبكات أكثر دقة وفعالية، كما أن النتائج العملية تجاوزت الفهم النظري بمراحل عديدة. ولهذا، فإن تفاصيل كيفية عمل نموذج مُدَرَّب ليست واضحة في أغلب الأحيان، وقد تعودنا على اعتبار هذه النماذج صناديق سوداء.

بشكل عام، ليس لدينا أية مشكلة مع هذا الغموض فيما يتعلق مثلاً بالنماذج التي تمارس لعبة جو أو تضع توصيات المسلسلات على نتفليكس. ولكن إذا أردنا استخدام الذكاء الاصطناعي لاتخاذ قرارات تتعلق بفرض القانون والتشخيص الطبي والسيارات ذاتية القيادة، فحينئذٍ يجب أن نفهم كيف توصّلَ إلى هذه القرارات، ونتمكن من تمييز القرارات الخاطئة.

تقول آيريس هاولي، وهي عالمة حاسوب بجامعة ويليامز في ويليامزتاون في ماساتشوستس، إن الناس في حاجة إلى إتاحة إمكانية الاختلاف مع هذه القرارات المؤتمتة أو الاعتراض عليها، وإلا سينبذون هذه التكنولوجيا ويقفون في وجهها، وتقول: "يمكنك أن ترى هذه المسألة حالياً في استجابة الناس لأنظمة التعرف على الوجوه".

ينتمي إحسان إلى مجموعة صغيرة ولكنها متنامية من الباحثين الذين يحاولون تحسين قدرة أنظمة الذكاء الاصطناعي على توضيح نفسها، ومساعدتنا على النظر داخل الصندوق الأسود. ويمكن تلخيص هدف ما يسمى بالذكاء الاصطناعي القابل للتفسير أو الشرح (XAI) بمساعدة الناس على استيعاب ميزات البيانات التي تتعلمها الشبكة العصبونية فعلياً، وبالتالي مدى دقة النموذج وبعده عن التحيز.

يقوم أحد الحلول على بناء أنظمة تعلم آلي تعرض كيفية عملها، التي يُصطلح على تسميتها بالصناديق الزجاجية، في تقابل واضح مع مفهوم الصندوق الأسود. عادة ما تكون هذه النماذج نسخاً مبسطة إلى حد كبير من الشبكات العصبونية، بحيث يسهل تتبع تأثير الأجزاء المختلفة من البيانات على النموذج. تقول جنيفر وورتمان فوجان، وهي عالمة حاسوب في قسم الأبحاث في مايكروسوفت: "هناك أفراد في الأوساط المختصة ممن يدعمون استخدام نماذج الصناديق الزجاجية في أي مجال حساس. وأتفق معهم إلى حد كبير". يمكن أن تضاهي نماذج الصناديق الزجاجية في أدائها الشبكات العصبونية الأكثر تعقيداً في أنواع معينة من البيانات محددة الهيكلية، مثل الجداول الإحصائية، وبالنسبة لبعض التطبيقات، هذا كل ما تحتاجه.

ولكن هذا يعتمد على مجال التطبيق. فإذا أردنا التعلم من البيانات العشوائية والمعقدة مثل الصور والنصوص، فليس أمامنا سوى الشبكات العصبونية العميقة، وبالتالي الغامضة. إن تعقيد هذه الشبكات العصبونية يحد من قدرتها على توضيح الصلات الهامة بين أعداد كبيرة للغاية من الميزات المتفرقة.

ولكن حتى هنا، قد يكون تعلم الصناديق الزجاجية نافعاً. ويقوم أحد الحلول على تمرير البيانات مرتين في نموذج صندوق زجاجي أولي لتدريبه كخطوة تدقيق لكشف الأخطاء المحتملة التي قد ترغب في تصحيحها. وما أن يتم تنظيف البيانات، يمكن تدريب نموذج صندوق أسود أكثر دقة.

غير أن هذه الطريقة تحتاج إلى توازن حساس، فقد تؤدي زيادة الشفافية إلى إثقال النموذج بالمعلومات. وفي دراسة تعود إلى 2018 حول تفاعل المستخدمين المحترفين مع أدوات التعلم الآلي، وجدت فوجان أن النماذج الشفافة يمكن في الواقع أن تزيد من صعوبة كشف وتصحيح أخطاء النموذج.

تقوم طريقة أخرى على استخدام أساليب عرض مرئية تبين بضعة ميزات أساسية للنموذج والبيانات التي يحويها. وتتلخص الفكرة في أن نظرة واحدة تكفي لرؤية المشاكل الكبيرة. وعلى سبيل المثال، فقد يعتمد النموذج إلى حد كبير على ميزات معينة، مما قد يشير إلى وجود التحيز.

حققت هذه الأدوات المرئية شعبية واسعة خلال الفترة القصيرة التي استُخدمت فيها. ولكن هل هي مفيدة فعلاً؟ في أول دراسة من نوعها، حاولت فوجان وفريقها الإجابة عن هذا التساؤل، وتمكنوا من كشف بعض المشاكل الكبيرة.

قام الفريق بدراسة أداتين واسعتي الانتشار لتفسير عمل النماذج، اللتين تقدمان نظرة عامة عن النموذج باستخدام الأشكال التوضيحية والخطوط البيانية للبيانات، بحيث توضح الأشياء التي التقطتها الشبكة العصبونية أكثر من غيرها أثناء التدريب. استعان الفريق بستة محترفين في التعلم الآلي من مايكروسوفت، ويختلفون جميعاً من حيث الدراسة ومهام العمل والخبرة. شارك هؤلاء المحترفون في محاكاة للتفاعل مع شبكة عصبونية عميقة مدربة على مجموعة وطنية لبيانات الدخل من الإحصاء السكاني لعام 1994 في الولايات المتحدة. صُممت التجربة تحديداً لمحاكاة طريقة استخدام علماء البيانات لأدوات التوضيح في المهام التي يتعاملون معها بشكل دائم.

اكتشف الفريق نتائج مذهلة؛ فلا شك في أن الأدوات كانت تساعد في بعض الأحيان على كشف القيم المفقودة في البيانات، ولكن هذه الفائدة فقدت قيمتها عندما طغى عليها ميل إلى الثقة الزائدة بالمعلومات المرئية وإساءة قراءتها. ففي بعض الحالات، لم يتمكن المستخدمون حتى من توصيف ما تعرضه الأدوات المرئية، وهو ما أدى إلى افتراضات خاطئة حول مجموعة البيانات والنماذج والأدوات نفسها، وأدى إلى بناء ثقة زائفة بالأدوات وجعل المشاركين أقرب إلى الطيش في تطبيق النماذج، حتى عند الشعور بوجود خطأ ما. ومن المثير للقلق أن هذا كان صحيحاً حتى عندما تلاعب الفريق بالأدوات لعرض توضيحات غير منطقية.

ومن أجل تدعيم النتائج التي نتجت عن هذه الدراسة الصغيرة، قام الباحثون بإجراء استبيان على الإنترنت لحوالي 200 شخص من محترفي التعلم الآلي، تم تجميعهم عن طريق قوائم التراسل بالبريد الإلكتروني ومنصات التواصل الاجتماعي، ووجدوا نتائج مشابهة من حيث الارتباك والثقة الخاطئة.

أما الأسوأ من هذا، فهو أن المشاركين كانوا سعداء لاستخدام الأدوات المرئية في اتخاذ القرارات حول تطبيق النماذج على الرغم من اعترافهم بعدم فهم الأسس الرياضية التي تعتمد عليها. تقول هارمانبريت كاور من جامعة ميشيغان، وهي مؤلفة مشاركة في البحث: "لقد كان من المفاجئ على نحو خاص رؤية المختصين يفسرون الشذوذات في البيانات عن طريق ابتداع روايات تشرحها. لقد كان تحيز الأتمتة أحد العوامل الهامة التي لم نأخذها بعين الاعتبار".

أجل... تحيز البيانات. أي أن الناس يميلون إلى الثقة بالحواسيب، وهي ليست بالظاهرة الجديدة؛ فقد أظهرت الدراسات أن البشر غالباً ما يتقبلون الخيارات التي تتخذها الأنظمة المؤتمتة، بدءاً من الربان الآلي في الطائرات وصولاً إلى أنظمة تدقيق التهجئة، حتى لو كانت مخطئة بشكل واضح. ولكن عندما حدث هذا مع أدوات مصممة لمساعدتنا على تجنب هذه الظاهرة نفسها، فإننا نتعرض حتى لمشكلة أكبر.

ماذا يمكننا أن نفعل حيال هذا الوضع؟ بالنسبة للبعض، يكمن جزء من المشكلة حول أول موجة من أنظمة الذكاء الاصطناعي القابلة للشرح في أنها تخضع لهيمنة باحثي التعلم الآلي، ومعظمهم من الخبراء في استخدام أنظمة الذكاء الاصطناعي. يقول تيم ميلر من جامعة ميلبورن، الذي يدرس استخدام البشر لأنظمة الذكاء الاصطناعي: "هذا يعني أن المجانين هم من يديرون المصح العقلي".

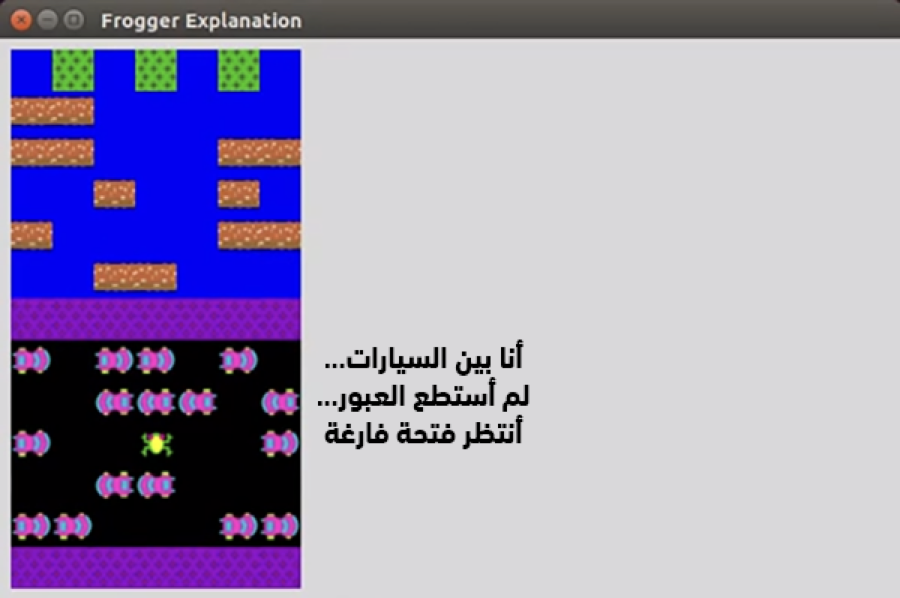

هذا ما أدركه إحسان وهو جالس في المقعد الخلفي في سيارة أوبر. فمن السهل استيعاب ما يفعله النظام المؤتمت، ورؤية لحظة ارتكاب الخطأ، إذا قدّم الأسباب الكامنة خلف أفعاله كما يفعل البشر. ويعمل إحسان وزميله مارك ريدل على تطوير نظام تعلم آلي يقوم آلياً بتوليد تفسيرات مماثلة باستخدام اللغة الطبيعية. وفي أحد النماذج الأولية، أخذ الباحثان شبكة عصبونية تعلمت كيفية اللعب بلعبة الفيديو الكلاسيكية فروجر التي تعود إلى الثمانينيات، وقاموا بتدريبها على تقديم سبب لكل حركة تقوم بها.

لقطة شاشة للبرنامج التفسيري لخوارزمية اللعب بلعبة فروجر، والتي صممها إحسان وريدل.

مصدر الصورة: أوبول إحسان

لتحقيق هذا، قام الباحثان بتدريب النظام على أمثلة كثيرة عن بشر يلعبون باللعبة ويتحدثون بصوت مرتفع عما يفعلونه. ومن ثم اخذا شبكة عصبونية للترجمة بين لغتين طبيعيتين وقاما بتعديلها لتحويل الأفعال في اللعبة إلى توضيحات باللغة الطبيعية لهذه الأفعال. والآن، عندما ترى الشبكة العصبونية فعلاً ما في اللعبة، تقوم "بترجمته" إلى تفسير. وحصل الباحثان بالنتيجة على نظام ذكاء اصطناعي يلعب بلعبة فروجر ويقول أشياء مثل "سأتحرك يساراً حتى أبقى خلف الشاحنة الزرقاء" في كل مرة يتحرك فيها.

ليس عمل إحسان وريدل سوى البداية؛ حيث إنه ليس من الواضح ما إذا كان نظام التعلم الآلي سيتمكن على الدوام من تقديم تبرير لأفعاله باللغة الطبيعية. فإذا أخذنا مثالاً نظامَ الذكاء الاصطناعي ألفازيرو من ديب مايند، الذي يلعب بالألعاب اللوحية، فإن واحدة من أبرز ميزاته هي القدرة على اتخاذ حركات فائزة لا يفكر معظم اللاعبين البشر في تجربتها خلال تلك المرحلة من اللعب. وإذا تمكن ألفازيرو من تفسير حركاته، فهل ستكون معقولة بالنسبة لنا على الدوام؟

يقول إحسان إن الأسباب مفيدة، سواء فهمناها أم لا: "إن هدف نظام الذكاء الاصطناعي القابل للتفسير -والذي يتمحور حول الانسان- ليس فقط الحصول على موافقة المستخدم لما يقوله الذكاء الاصطناعي، بل أيضاً تحفيزه على التفكير". ويستذكر ريدل مشاهدة بث حي للمسابقة بين برنامج ديب مايند وبطل لعبة جو الكوري لي سيدول؛ حيث كان المعلقون يتحدثون عما كان ألفاجو يراه ويفكر فيه. يقول ريدل: "لم تكن هذه طريقة عمل ألفاجو. ولكنني أحسست كأن التعليق كان أساسياً لفهم ما كان يحدث".

ما يتفق عليه أفراد هذه الموجة الجديدة من الباحثين في مجال الذكاء الاصطناعي القابل للشرح هو أنه إذا كانت أنظمة الذكاء الاصطناعي ستُستخدم من قِبل المزيد من البشر، فيجب أن يكون هؤلاء البشر جزءاً من عملية التصميم منذ البداية، ويجب أن نراعي حاجة الأنواع المختلفة من الناس إلى شروحات مختلفة، وهو ما تدعمه دراسة جديدة من هاولي وزملائها، التي تبين أن قدرة الناس على فهم تمثيل مرئي تفاعلي أو سكوني تعتمد على مستواهم التعليمي. ويقول إحسان إن نظام الذكاء الاصطناعي المخصص لتشخيص السرطان، على سبيل المثال، يجب أن يكون قادراً على تقديم التفسيرات المناسبة للمريض، التي ستكون مختلفة كلياً عن التفسيرات التي سيقدمها لطبيب مختص بالأورام.

في المحصلة، نرغب في أن تقوم أنظمة الذكاء الاصطناعي بتفسير طريقة عملها للجميع، لا فقط علماء البيانات والأطباء، بل أيضاً ضباط الشرطة الذين يستخدمون تكنولوجيا التعرف على الوجوه، والمدرسين الذين يستخدمون برمجيات التحليل في غرف الصف، والطلاب الذين يحاولون استيعاب الصفحة الرئيسية للأخبار في منصات التواصل الاجتماعي، وطبعاً، أي شخص يجلس في المقعد الخلفي لسيارة ذاتية القيادة.

يقول ريدل: "لطالما علمنا بأن الناس يبالغون في ثقتهم بالتكنولوجيا، وهذا صحيح على وجه الخصوص بالنسبة لأنظمة الذكاء الاصطناعي. وكلما قلنا إن النظام ذكي، ازدادت قناعة الناس بأنه أكثر ذكاء مما هو عليه فعلياً". وبالتالي، يجب أن نقدم شروحات يستوعبها الجميع، بحيث نتمكن أخيراً من القضاء على هذه الفقاعة.

نشر هذا المقال في 20 مارس 2020 على موقع مجلة "إم آي تي تكنولوجي ريفيو".